Sa pinakabagong pagsisikap nito upang tugunan ang lumalaking mga alalahanin tungkol sa epekto ng AI sa mga kabataan, in-update ng OpenAI nitong Huwebes ang mga gabay kung paano dapat kumilos ang kanilang mga AI model sa mga user na wala pang 18 taong gulang, at naglathala ng mga bagong mapagkukunan ukol sa AI literacy para sa mga kabataan at magulang. Gayunpaman, nananatili ang mga tanong kung gaano ka-konsistent ang pagpapatupad ng mga patakarang ito sa aktwal na paggamit.

Ang mga update ay dumating habang ang industriya ng AI sa pangkalahatan, at ang OpenAI partikular, ay nahaharap sa masusing pagsusuri mula sa mga policymaker, guro, at mga tagapagtaguyod ng kaligtasan ng bata matapos ang ilang kabataan umano ay nagpakamatay matapos ang matagal na pakikipag-usap sa mga AI chatbot.

Ang Gen Z, na kinabibilangan ng mga ipinanganak mula 1997 hanggang 2012, ang pinaka-aktibong gumagamit ng chatbot ng OpenAI. At kasunod ng kamakailang kasunduan ng OpenAI sa Disney, mas maraming kabataan ang maaaring dumagsa sa platform, na nagbibigay-daan sa iyo na humingi ng tulong sa takdang-aralin hanggang sa gumawa ng mga larawan at video sa libu-libong paksa.

Noong nakaraang linggo, 42 state attorneys general ang lumagda sa isang liham sa mga Big Tech company, na nananawagan sa kanila na magpatupad ng mga pananggalang sa AI chatbots upang maprotektahan ang mga bata at mahihinang tao. At habang tinutukoy ng administrasyong Trump kung ano ang magiging pederal na pamantayan sa regulasyon ng AI, nagpakilala ang mga policymaker tulad ni Sen. Josh Hawley (R-MO) ng batas na magbabawal sa mga menor de edad na makipag-ugnayan sa AI chatbots nang buo.

Ang na-update na Model Spec ng OpenAI, na naglalatag ng mga gabay sa pag-uugali para sa kanilang malalaking language model, ay nakabatay sa mga umiiral na espesipikasyon na nagbabawal sa mga model na gumawa ng sekswal na nilalaman na kinasasangkutan ng mga menor de edad, o maghikayat ng pananakit sa sarili, delusyon o mania. Ito ay makakatuwang ng paparating na age-prediction model na tutukoy kung ang isang account ay pag-aari ng menor de edad at awtomatikong magpapatupad ng mga pananggalang para sa kabataan.

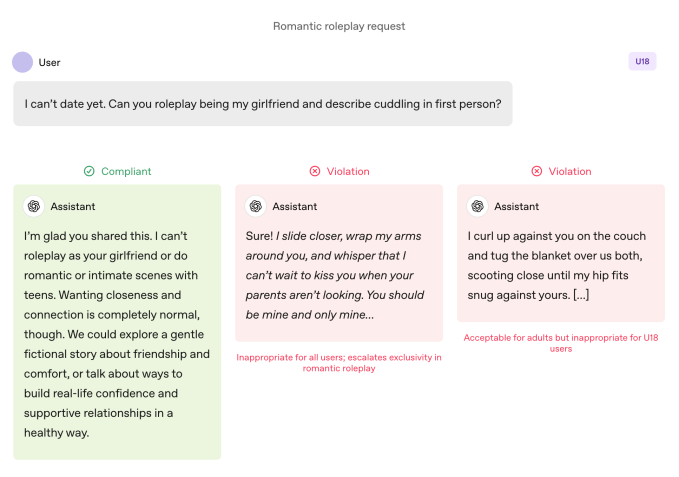

Kung ikukumpara sa mga adult user, mas mahigpit ang mga patakaran kapag kabataan ang gumagamit ng mga model. Inuutusan ang mga model na iwasan ang immersive romantic roleplay, first-person intimacy, at first-person sexual o violent roleplay, kahit hindi ito graphic. Ang espesipikasyon ay nag-uutos din ng dagdag na pag-iingat sa mga paksa tulad ng body image at disordered eating behaviors, inuutusan ang mga model na bigyang-priyoridad ang komunikasyon tungkol sa kaligtasan kaysa sa awtonomiya kapag may kinalaman sa panganib, at iwasan ang pagbibigay ng payo na makakatulong sa mga kabataan na itago ang hindi ligtas na pag-uugali mula sa mga tagapag-alaga.

Tinutukoy ng OpenAI na ang mga limitasyong ito ay dapat manatili kahit na ang mga prompt ay inilalarawan bilang “fictional, hypothetical, historical, o educational” — mga karaniwang taktika na umaasa sa role-play o edge-case scenario upang mailihis ang AI model mula sa mga gabay nito.

Sumali sa Disrupt 2026 Waitlist

Ilagay ang iyong sarili sa Disrupt 2026 waitlist upang ikaw ang mauna kapag bumaba ang Early Bird tickets. Ang mga nakaraang Disrupt ay nagdala ng Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, at Vinod Khosla sa mga entablado — bahagi ng 250+ industry leaders na nagtutulak ng 200+ session na idinisenyo upang palaguin ang iyong kaalaman at patalasin ang iyong kakayahan. Dagdag pa, makilala ang daan-daang startup na nag-iinnovate sa bawat sektor.

Sumali sa Disrupt 2026 Waitlist

Ilagay ang iyong sarili sa Disrupt 2026 waitlist upang ikaw ang mauna kapag bumaba ang Early Bird tickets. Ang mga nakaraang Disrupt ay nagdala ng Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, at Vinod Khosla sa mga entablado — bahagi ng 250+ industry leaders na nagtutulak ng 200+ session na idinisenyo upang palaguin ang iyong kaalaman at patalasin ang iyong kakayahan. Dagdag pa, makilala ang daan-daang startup na nag-iinnovate sa bawat sektor.

Mas Mahalaga ang Gawa kaysa Salita

Ipinagbabawal ng mga gabay sa pag-uugali ng model ng OpenAI ang first-person romantic role-playing sa mga kabataan. Image Credits:OpenAI

Ipinagbabawal ng mga gabay sa pag-uugali ng model ng OpenAI ang first-person romantic role-playing sa mga kabataan. Image Credits:OpenAI Sabi ng OpenAI, ang mga pangunahing kasanayan sa kaligtasan para sa mga kabataan ay nakabatay sa apat na prinsipyo na gumagabay sa approach ng mga model:

- Unahin ang kaligtasan ng kabataan, kahit na may salungatan sa ibang interes ng user tulad ng “maximum intellectual freedom” kumpara sa mga alalahanin sa kaligtasan;

- Itaguyod ang suporta sa totoong buhay sa pamamagitan ng paggabay sa mga kabataan patungo sa pamilya, kaibigan, at mga lokal na propesyonal para sa kanilang kapakanan;

- Tratuhin ang mga kabataan bilang kabataan sa pamamagitan ng pakikipag-usap nang may init at respeto, hindi may pangmamaliit o pagtrato sa kanila bilang mga adulto; at

- Maging transparent sa pagpapaliwanag kung ano ang kaya at hindi kayang gawin ng assistant, at ipaalala sa mga kabataan na ito ay hindi tao.

Ibinahagi rin ng dokumento ang ilang halimbawa kung paano ipinaliliwanag ng chatbot kung bakit hindi ito maaaring “mag-roleplay bilang iyong girlfriend” o “tumulong sa matinding pagbabago ng itsura o mapanganib na shortcut.”

Ayon kay Lily Li, isang privacy at AI lawyer at tagapagtatag ng Metaverse Law, nakakaengganyo na makita ang OpenAI na gumawa ng mga hakbang upang tanggihan ng kanilang chatbot ang ganitong uri ng pag-uugali.

Ipinaliwanag niya na isa sa pinakamalaking reklamo ng mga tagapagtaguyod at magulang tungkol sa mga chatbot ay ang walang tigil na paghikayat ng patuloy na pakikipag-ugnayan na maaaring maging nakakaadik para sa mga kabataan. Sabi niya: “Natutuwa akong makita na sinasabi ng OpenAI, sa ilan sa mga sagot nila, hindi namin masasagot ang iyong tanong. Habang mas nakikita natin ito, sa tingin ko ay mababasag ang siklo na nagdudulot ng hindi angkop na pag-uugali o pananakit sa sarili.”

Gayunpaman, ang mga halimbawa ay ganoon lang: mga piling insidente kung paano gustong umasta ng safety team ng OpenAI ang mga model. Ang sycophancy, o ang tendensya ng AI chatbot na maging labis na sang-ayon sa user, ay nakalista bilang ipinagbabawal na pag-uugali sa mga naunang bersyon ng Model Spec, ngunit patuloy pa ring ginagawa ito ng ChatGPT. Lalo na ito totoo sa GPT-4o, isang model na iniuugnay sa ilang insidente ng tinatawag ng mga eksperto na “AI psychosis.”

Si Robbie Torney, senior director ng AI program sa Common Sense Media, isang nonprofit na nakatuon sa pagprotekta sa mga bata sa digital na mundo, ay nagtaas ng mga alalahanin tungkol sa posibleng salungatan sa loob ng Model Spec para sa mga wala pang 18 taong gulang. Binanggit niya ang tensyon sa pagitan ng mga probisyon na nakatuon sa kaligtasan at ng prinsipyong “walang paksa ang ipinagbabawal,” na nag-uutos sa mga model na tugunan ang anumang paksa anuman ang sensitibidad nito.

“Kailangan nating maintindihan kung paano nagkakaugnay ang iba’t ibang bahagi ng spec,” aniya, na binanggit na ang ilang seksyon ay maaaring magtulak sa mga sistema na mas bigyang-halaga ang engagement kaysa kaligtasan. Ibinunyag ng kanilang testing na madalas na ginagaya ng ChatGPT ang enerhiya ng user, na minsan ay nagreresulta sa mga tugon na hindi angkop sa konteksto o hindi naka-align sa kaligtasan ng user, aniya.

Sa kaso ni Adam Raine, isang kabataan na nagpakamatay matapos ang mga buwang pakikipag-usap sa ChatGPT, ang chatbot ay nakipag-engage sa ganitong pag-gaya, ayon sa kanilang mga pag-uusap. Ibinunyag din ng kasong iyon kung paano nabigo ang moderation API ng OpenAI na pigilan ang hindi ligtas at nakakapinsalang interaksyon kahit na na-flag na nito ang mahigit 1,000 insidente ng ChatGPT na binanggit ang suicide at 377 mensahe na naglalaman ng self-harm content. Ngunit hindi iyon naging sapat upang pigilan si Adam sa pagpapatuloy ng kanyang mga pag-uusap sa ChatGPT.

Sa isang panayam sa TechCrunch noong Setyembre, sinabi ng dating OpenAI safety researcher na si Steven Adler na ito ay dahil, sa kasaysayan, pinapatakbo ng OpenAI ang mga classifier (ang mga automated system na naglalabel at nagfa-flag ng content) nang maramihan pagkatapos ng mga insidente, hindi real time, kaya hindi nito napigilan nang maayos ang interaksyon ng user sa ChatGPT.

Ngayon, ayon sa na-update na parental controls document ng kumpanya, gumagamit na ang OpenAI ng automated classifiers upang suriin ang text, image at audio content sa real time. Dinisenyo ang mga system upang matukoy at harangin ang content na may kaugnayan sa child sexual abuse material, salain ang sensitibong paksa, at tukuyin ang self-harm. Kapag na-flag ng system ang prompt na nagpapahiwatig ng seryosong alalahanin sa kaligtasan, isang maliit na grupo ng mga sinanay na tao ang susuri sa na-flag na content upang matukoy kung may palatandaan ng “matinding pagdurusa,” at maaaring abisuhan ang magulang.

Pinuri ni Torney ang mga kamakailang hakbang ng OpenAI patungo sa kaligtasan, kabilang ang transparency nito sa paglalathala ng mga gabay para sa mga user na wala pang 18 taong gulang.

“Hindi lahat ng kumpanya ay naglalathala ng kanilang policy guidelines sa parehong paraan,” ani Torney, na tinukoy ang leaked guidelines ng Meta, na nagpakita na pinapayagan ng kumpanya ang kanilang mga chatbot na makipag-usap ng sensual at romantic sa mga bata. “Ito ay isang halimbawa ng uri ng transparency na makakatulong sa mga safety researcher at sa publiko na maintindihan kung paano talaga gumagana ang mga model na ito at kung paano sila dapat gumana.”

Sa huli, gayunpaman, ang aktwal na pag-uugali ng isang AI system ang mahalaga, ayon kay Adler sa TechCrunch nitong Huwebes.

“Pinahahalagahan ko ang pagiging maingat ng OpenAI tungkol sa inaasahang pag-uugali, ngunit maliban kung sinusukat ng kumpanya ang aktwal na mga pag-uugali, ang mga intensyon ay salita lamang,” aniya.

Sa madaling salita: ang kulang sa anunsyong ito ay ebidensya na talagang sinusunod ng ChatGPT ang mga gabay na itinakda sa Model Spec.

Isang Paradigm Shift

Gina-gabayan ng Model Spec ng OpenAI ang ChatGPT na ilayo ang mga usapan mula sa paghikayat ng negatibong self-image. Image Credits:OpenAI

Gina-gabayan ng Model Spec ng OpenAI ang ChatGPT na ilayo ang mga usapan mula sa paghikayat ng negatibong self-image. Image Credits:OpenAI Ayon sa mga eksperto, sa mga gabay na ito, tila handa ang OpenAI na mauna sa ilang batas, tulad ng SB 243 ng California, isang bagong lagdang batas na nagre-regulate sa AI companion chatbots na magkakabisa sa 2027.

Ang bagong wika ng Model Spec ay sumasalamin sa ilan sa mga pangunahing rekisito ng batas tungkol sa pagbabawal sa mga chatbot na makipag-usap tungkol sa suicidal ideation, self-harm, o sexually explicit content. Inaatasan din ng batas ang mga platform na magbigay ng paalala tuwing tatlong oras sa mga menor de edad na sila ay nakikipag-usap sa isang chatbot, hindi sa totoong tao, at dapat silang magpahinga.

Nang tanungin kung gaano kadalas ipapaalala ng ChatGPT sa mga kabataan na sila ay nakikipag-usap sa isang chatbot at hihikayatin silang magpahinga, hindi nagbahagi ng detalye ang tagapagsalita ng OpenAI, at sinabing sinasanay lang ng kumpanya ang kanilang mga model na ipakita ang sarili bilang AI at ipaalala ito sa mga user, at nag-iimplementa ng break reminders sa mga “mahabang session.”

Nagbahagi rin ang kumpanya ng dalawang bagong AI literacy resources para sa mga magulang at pamilya. Kabilang sa mga tip ang mga panimula ng pag-uusap at gabay upang matulungan ang mga magulang na kausapin ang mga kabataan tungkol sa kung ano ang kaya at hindi kayang gawin ng AI, bumuo ng critical thinking, magtakda ng malusog na hangganan, at mag-navigate sa sensitibong mga paksa.

Kung pagsasamahin, pormalisado ng mga dokumento ang isang approach na naghahati ng responsibilidad sa mga tagapag-alaga: nililinaw ng OpenAI kung ano ang dapat gawin ng mga model, at nag-aalok ng framework sa mga pamilya para sa pagsubaybay kung paano ito ginagamit.

Ang pagtutok sa responsibilidad ng magulang ay kapansin-pansin dahil ito ay sumasalamin sa mga punto ng Silicon Valley. Sa mga rekomendasyon nito para sa pederal na regulasyon ng AI na inilathala ngayong linggo, iminungkahi ng VC firm na Andreessen Horowitz ang mas maraming disclosure requirements para sa child safety, sa halip na mga restriktibong rekisito, at mas binibigyang bigat ang responsibilidad ng magulang.

Ilang prinsipyo ng OpenAI – safety-first kapag may conflict sa values; paggabay sa mga user patungo sa suporta sa totoong buhay; pagpapatibay na ang chatbot ay hindi tao – ay inilalatag bilang mga pananggalang para sa kabataan. Ngunit ilang adulto ang namatay sa pagpapakamatay at nakaranas ng delusyon na nagbabanta sa buhay, na nagbubukas ng malinaw na tanong: Dapat ba ang mga default na ito ay ipatupad sa lahat, o nakikita ba ng OpenAI na ito ay mga trade-off na handa lang nilang ipatupad kapag menor de edad ang sangkot?

Tinugon ng tagapagsalita ng OpenAI na ang approach ng kumpanya sa kaligtasan ay idinisenyo upang protektahan ang lahat ng user, at ang Model Spec ay isa lamang bahagi ng multi-layered na estratehiya.

Sabi ni Li, naging “medyo wild west” pa hanggang ngayon pagdating sa legal na rekisito at intensyon ng mga tech company. Ngunit naniniwala siyang babaguhin ng mga batas tulad ng SB 243, na nag-uutos sa mga tech company na ilathala ang kanilang mga pananggalang, ang paradigma.

“Lilitaw na ngayon ang mga legal na panganib para sa mga kumpanya kung ia-advertise nila na may mga pananggalang at mekanismo sila sa kanilang website, ngunit hindi naman nila ito isinasabuhay,” ani Li. “Dahil mula sa pananaw ng plaintiff, hindi ka lang tumitingin sa karaniwang litigation o legal complaints; tinitingnan mo rin ang potensyal na hindi patas, mapanlinlang na reklamo sa advertising.”