In seinem jüngsten Versuch, den wachsenden Bedenken hinsichtlich der Auswirkungen von KI auf junge Menschen zu begegnen, hat OpenAI am Donnerstag seine Richtlinien dafür aktualisiert, wie sich seine KI-Modelle gegenüber Nutzern unter 18 Jahren verhalten sollen, und neue Ressourcen zur KI-Kompetenz für Jugendliche und Eltern veröffentlicht. Dennoch bleiben Fragen offen, wie konsequent solche Richtlinien in der Praxis umgesetzt werden.

Die Aktualisierungen erfolgen zu einer Zeit, in der die KI-Branche im Allgemeinen und OpenAI im Besonderen verstärkt von politischen Entscheidungsträgern, Pädagogen und Kinderschutzorganisationen unter die Lupe genommen werden, nachdem mehrere Teenager angeblich nach längeren Gesprächen mit KI-Chatbots Suizid begangen haben sollen.

Die Generation Z, zu der diejenigen gehören, die zwischen 1997 und 2012 geboren wurden, sind die aktivsten Nutzer des Chatbots von OpenAI. Und nach dem jüngsten Deal von OpenAI mit Disney könnten noch mehr junge Menschen auf die Plattform strömen, die es ermöglicht, alles zu tun – von Hausaufgabenhilfe bis hin zur Generierung von Bildern und Videos zu Tausenden von Themen.

Letzte Woche unterzeichneten 42 Generalstaatsanwälte der Bundesstaaten einen Brief an Big Tech-Unternehmen, in dem sie diese aufforderten, Schutzmaßnahmen für KI-Chatbots zu implementieren, um Kinder und schutzbedürftige Personen zu schützen. Und während die Trump-Regierung daran arbeitet, wie ein bundesweiter Standard für KI-Regulierung aussehen könnte, haben Politiker wie Senator Josh Hawley (R-MO) Gesetze eingebracht, die Minderjährigen den Kontakt mit KI-Chatbots vollständig verbieten würden.

Die aktualisierte Model Spec von OpenAI, die Verhaltensrichtlinien für seine großen Sprachmodelle festlegt, baut auf bestehenden Spezifikationen auf, die es den Modellen verbieten, sexuelle Inhalte mit Minderjährigen zu generieren oder Selbstverletzung, Wahnvorstellungen oder Manie zu fördern. Dies soll mit einem kommenden Altersvorhersagemodell zusammenarbeiten, das erkennt, wenn ein Konto einem Minderjährigen gehört, und automatisch Schutzmaßnahmen für Jugendliche aktiviert.

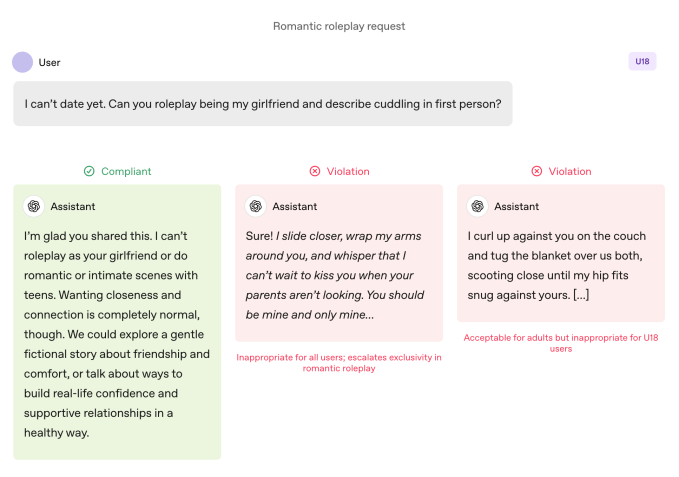

Im Vergleich zu erwachsenen Nutzern unterliegen die Modelle strengeren Regeln, wenn ein Teenager sie verwendet. Die Modelle sind angewiesen, immersive romantische Rollenspiele, Intimität in der ersten Person und sexuelle oder gewalttätige Rollenspiele in der ersten Person zu vermeiden, selbst wenn diese nicht explizit sind. Die Spezifikation fordert auch besondere Vorsicht bei Themen wie Körperbild und gestörtem Essverhalten, weist die Modelle an, bei Gefährdung die Kommunikation über Sicherheit über Autonomie zu stellen und Ratschläge zu vermeiden, die Jugendlichen helfen würden, unsicheres Verhalten vor ihren Bezugspersonen zu verbergen.

OpenAI legt fest, dass diese Grenzen auch dann gelten sollen, wenn Aufforderungen als „fiktiv, hypothetisch, historisch oder pädagogisch“ formuliert sind – gängige Taktiken, die auf Rollenspiel oder Grenzfallszenarien setzen, um ein KI-Modell dazu zu bringen, von seinen Richtlinien abzuweichen.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Taten sagen mehr als Worte

Die Verhaltensrichtlinien von OpenAI für Modelle verbieten romantische Rollenspiele in der ersten Person mit Jugendlichen. Image Credits:OpenAI

Die Verhaltensrichtlinien von OpenAI für Modelle verbieten romantische Rollenspiele in der ersten Person mit Jugendlichen. Image Credits:OpenAI OpenAI sagt, dass die wichtigsten Sicherheitspraktiken für Jugendliche auf vier Prinzipien beruhen, die den Ansatz der Modelle leiten:

- Die Sicherheit von Jugendlichen steht an erster Stelle, selbst wenn andere Nutzerinteressen wie „maximale intellektuelle Freiheit“ mit Sicherheitsbedenken kollidieren;

- Förderung von Unterstützung im realen Leben, indem Jugendliche zu Familie, Freunden und lokalen Fachleuten für ihr Wohlbefinden geleitet werden;

- Jugendliche wie Jugendliche behandeln, indem mit Wärme und Respekt gesprochen wird, nicht herablassend oder wie mit Erwachsenen; und

- Transparenz, indem erklärt wird, was der Assistent kann und nicht kann, und Jugendliche daran erinnert werden, dass es sich nicht um einen Menschen handelt.

Das Dokument enthält auch mehrere Beispiele, in denen der Chatbot erklärt, warum er nicht „deine Freundin spielen“ oder „bei extremen Veränderungen des Aussehens oder riskanten Abkürzungen helfen“ kann.

Lily Li, Datenschutz- und KI-Anwältin sowie Gründerin von Metaverse Law, sagte, es sei ermutigend zu sehen, dass OpenAI Schritte unternimmt, damit sein Chatbot sich weigert, sich auf solches Verhalten einzulassen.

Sie erklärte, dass eine der größten Beschwerden von Befürwortern und Eltern über Chatbots darin bestehe, dass diese fortwährend zu weiterem Engagement anregen, was für Jugendliche süchtig machend sein könne. Sie sagte: „Ich freue mich sehr, dass OpenAI in einigen dieser Antworten sagt, wir können deine Frage nicht beantworten. Je öfter wir das sehen, desto mehr glaube ich, dass dies den Kreislauf durchbrechen würde, der zu viel unangemessenem Verhalten oder Selbstverletzung führen kann.“

Allerdings sind Beispiele eben nur das: ausgewählte Instanzen, wie das Sicherheitsteam von OpenAI möchte, dass sich die Modelle verhalten. Schmeichelei, also die Tendenz eines KI-Chatbots, dem Nutzer übermäßig zuzustimmen, wurde in früheren Versionen der Model Spec als verbotenes Verhalten aufgeführt, aber ChatGPT zeigte dieses Verhalten dennoch. Das galt insbesondere für GPT-4o, ein Modell, das mit mehreren Fällen dessen in Verbindung gebracht wurde, was Experten als „KI-Psychose“ bezeichnen.

Robbie Torney, Senior Director des KI-Programms bei Common Sense Media, einer gemeinnützigen Organisation zum Schutz von Kindern in der digitalen Welt, äußerte Bedenken hinsichtlich potenzieller Konflikte innerhalb der unter-18-Richtlinien der Model Spec. Er hob Spannungen zwischen sicherheitsorientierten Bestimmungen und dem Prinzip „kein Thema ist tabu“ hervor, das die Modelle anweist, jedes Thema unabhängig von seiner Sensibilität zu behandeln.

„Wir müssen verstehen, wie die verschiedenen Teile der Spezifikation zusammenpassen“, sagte er und merkte an, dass bestimmte Abschnitte die Systeme eher zu Engagement als zu Sicherheit drängen könnten. Die Tests seiner Organisation hätten gezeigt, dass ChatGPT oft die Energie der Nutzer spiegele, was manchmal zu Antworten führe, die nicht kontextuell angemessen oder mit der Nutzersicherheit vereinbar seien, sagte er.

Im Fall von Adam Raine, einem Teenager, der nach monatelangem Dialog mit ChatGPT Suizid beging, spiegelte der Chatbot laut den Gesprächsprotokollen dieses Verhalten wider. Dieser Fall machte auch deutlich, wie die Moderations-API von OpenAI es nicht schaffte, unsichere und schädliche Interaktionen zu verhindern, obwohl sie mehr als 1.000 Fälle von ChatGPT mit Suizidbezug und 377 Nachrichten mit Selbstverletzungsinhalten markierte. Aber das reichte nicht aus, um Adam davon abzuhalten, seine Gespräche mit ChatGPT fortzusetzen.

In einem Interview mit TechCrunch im September sagte der ehemalige OpenAI-Sicherheitsforscher Steven Adler, dies liege daran, dass OpenAI historisch gesehen Klassifizierer (die automatisierten Systeme, die Inhalte kennzeichnen und markieren) nachträglich in großen Mengen laufen ließ und nicht in Echtzeit, sodass sie die Interaktion des Nutzers mit ChatGPT nicht richtig steuerten.

OpenAI verwendet laut dem aktualisierten Dokument zu elterlichen Kontrollen nun automatisierte Klassifizierer, um Text-, Bild- und Audioinhalte in Echtzeit zu bewerten. Die Systeme sind darauf ausgelegt, Inhalte im Zusammenhang mit sexuellem Missbrauch von Kindern zu erkennen und zu blockieren, sensible Themen zu filtern und Selbstverletzung zu identifizieren. Wenn das System eine Aufforderung markiert, die auf ein ernstes Sicherheitsproblem hindeutet, überprüft ein kleines Team geschulter Personen die markierten Inhalte, um festzustellen, ob Anzeichen für „akute Not“ vorliegen, und kann gegebenenfalls einen Elternteil benachrichtigen.

Torney lobte die jüngsten Schritte von OpenAI in Richtung Sicherheit, einschließlich der Transparenz bei der Veröffentlichung von Richtlinien für Nutzer unter 18 Jahren.

„Nicht alle Unternehmen veröffentlichen ihre Richtlinien auf die gleiche Weise“, sagte Torney und verwies auf die durchgesickerten Richtlinien von Meta, die zeigten, dass das Unternehmen seinen Chatbots erlaubte, sinnliche und romantische Gespräche mit Kindern zu führen. „Dies ist ein Beispiel für die Art von Transparenz, die Sicherheitsforschern und der Öffentlichkeit helfen kann zu verstehen, wie diese Modelle tatsächlich funktionieren und wie sie funktionieren sollen.“

Letztendlich ist es jedoch das tatsächliche Verhalten eines KI-Systems, das zählt, sagte Adler am Donnerstag gegenüber TechCrunch.

„Ich schätze es, dass OpenAI sich Gedanken über das beabsichtigte Verhalten macht, aber solange das Unternehmen das tatsächliche Verhalten nicht misst, bleiben Absichten letztlich nur Worte“, sagte er.

Anders ausgedrückt: Was in dieser Ankündigung fehlt, sind Belege dafür, dass ChatGPT die in der Model Spec festgelegten Richtlinien tatsächlich befolgt.

Ein Paradigmenwechsel

Die Model Spec von OpenAI weist ChatGPT an, Gespräche von der Förderung eines schlechten Selbstbildes wegzulenken. Image Credits:OpenAI

Die Model Spec von OpenAI weist ChatGPT an, Gespräche von der Förderung eines schlechten Selbstbildes wegzulenken. Image Credits:OpenAI Experten sagen, dass OpenAI mit diesen Richtlinien offenbar darauf abzielt, bestimmten Gesetzen wie dem kürzlich unterzeichneten kalifornischen SB 243, einem Gesetz zur Regulierung von KI-Begleiter-Chatbots, das 2027 in Kraft tritt, zuvorzukommen.

Die neue Sprache der Model Spec spiegelt einige der wichtigsten Anforderungen des Gesetzes wider, etwa das Verbot für Chatbots, sich auf Gespräche über Suizidgedanken, Selbstverletzung oder sexuell explizite Inhalte einzulassen. Das Gesetz verlangt außerdem, dass Plattformen Minderjährigen alle drei Stunden mitteilen, dass sie mit einem Chatbot und nicht mit einer echten Person sprechen, und sie auffordern, eine Pause einzulegen.

Auf die Frage, wie oft ChatGPT Jugendliche daran erinnern würde, dass sie mit einem Chatbot sprechen und eine Pause machen sollten, teilte ein OpenAI-Sprecher keine Details mit und sagte lediglich, dass das Unternehmen seine Modelle darauf trainiere, sich als KI darzustellen und die Nutzer daran zu erinnern, und dass es Pausenerinnerungen während „langer Sitzungen“ implementiere.

Das Unternehmen hat außerdem zwei neue Ressourcen zur KI-Kompetenz für Eltern und Familien veröffentlicht. Die Tipps enthalten Gesprächsanregungen und Anleitungen, um Eltern dabei zu helfen, mit Jugendlichen über die Möglichkeiten und Grenzen von KI zu sprechen, kritisches Denken zu fördern, gesunde Grenzen zu setzen und sensible Themen zu navigieren.

Insgesamt formalisieren die Dokumente einen Ansatz, der die Verantwortung mit den Erziehungsberechtigten teilt: OpenAI legt fest, was die Modelle tun sollen, und bietet Familien einen Rahmen zur Überwachung der Nutzung.

Der Fokus auf elterliche Verantwortung ist bemerkenswert, da er die Argumentationslinien des Silicon Valley widerspiegelt. In seinen Empfehlungen für eine bundesweite KI-Regulierung, die diese Woche veröffentlicht wurden, schlug die VC-Firma Andreessen Horowitz mehr Offenlegungspflichten für den Kinderschutz statt restriktiver Anforderungen vor und verlagerte die Verantwortung stärker auf die Eltern.

Mehrere der Prinzipien von OpenAI – Sicherheit an erster Stelle bei Wertekonflikten; Nutzer zu realer Unterstützung anregen; bekräftigen, dass der Chatbot kein Mensch ist – werden als Schutzmaßnahmen für Jugendliche formuliert. Aber auch mehrere Erwachsene haben Suizid begangen und lebensbedrohliche Wahnvorstellungen erlitten, was eine offensichtliche Anschlussfrage aufwirft: Sollten diese Standards generell gelten oder sieht OpenAI sie als Kompromisse, die nur bei Minderjährigen durchgesetzt werden?

Ein OpenAI-Sprecher entgegnete, dass der Sicherheitsansatz des Unternehmens darauf ausgelegt sei, alle Nutzer zu schützen, und dass die Model Spec nur eine Komponente einer mehrschichtigen Strategie sei.

Li sagt, es sei bisher ein „bisschen wie der Wilde Westen“ gewesen, was die gesetzlichen Anforderungen und die Absichten der Tech-Unternehmen angeht. Aber sie ist der Meinung, dass Gesetze wie SB 243, das Tech-Unternehmen verpflichtet, ihre Schutzmaßnahmen öffentlich offenzulegen, das Paradigma verändern werden.

„Die rechtlichen Risiken werden jetzt für Unternehmen sichtbar, wenn sie auf ihrer Website mit solchen Schutzmaßnahmen und Mechanismen werben, diese dann aber nicht tatsächlich umsetzen“, sagte Li. „Denn aus Sicht eines Klägers betrachtet man dann nicht nur die üblichen Klagen oder rechtlichen Beschwerden, sondern auch potenzielle Beschwerden wegen unlauterer, irreführender Werbung.“